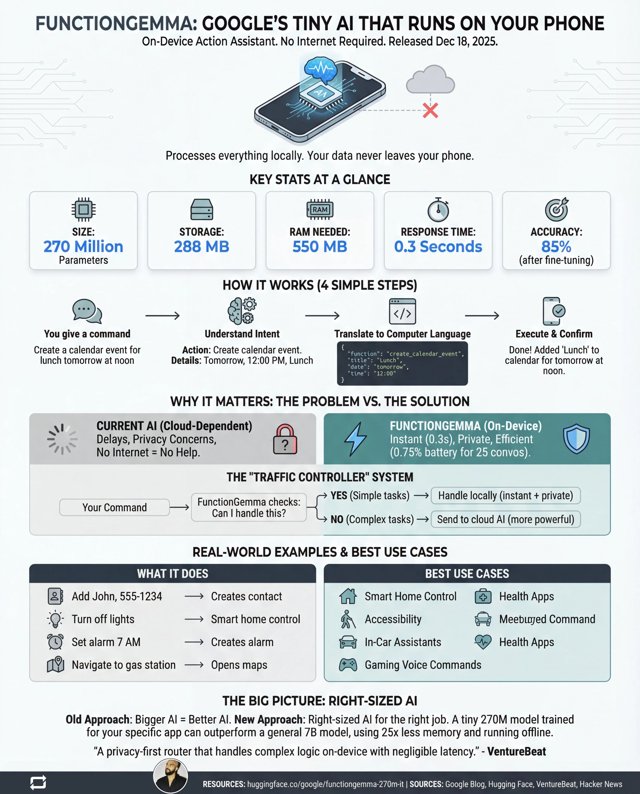

18 grudnia 2025 roku Google po cichu wypuścił FunctionGemma, malutki model AI z 270 milionami parametrów, zaprojektowany do działania całkowicie na urządzeniu. Informacja prasowa skupiała się na smartfonach — ustawianie przypomnień, włączanie latarki, standardowe rzeczy asystenta cyfrowego. Ale ukryte w tych specyfikacjach jest coś znacznie ciekawszego: plan drastycznego obniżenia kosztów robotów.

Oto brudny sekret dzisiejszych “inteligentnych” robotów: większość z nich wcale nie jest inteligentna. To terminale. Inteligencja mieszka gdzieś w centrum danych tysiące kilometrów stąd, połączona przez łącze internetowe, które dodaje opóźnienia, kosztuje pieniądze i zawodzi w momencie wejścia w martwą strefę. Za każdym razem, gdy twój robot magazynowy musi podjąć decyzję, dzwoni do domu jak nerwowy nastolatek proszący o pozwolenie.

FunctionGemma całkowicie zmienia te rachunki.

Liczby, które się liczą

Pominmy marketingowy bełkot i spójrzmy na to, co naprawdę ma znaczenie dla robotyki:

- 288 MB miejsca na dysku – Mieści się na najtańszych mikrokontrolerach

- 550 MB RAM – Raspberry Pi 4 ma 8 GB w zapasie

- 0,3 sekundy czasu odpowiedzi – Na urządzeniu, bez obiegu sieciowego

- 58% dokładności bazowej → 85% po fine-tuningu – Możliwość trenowania dla konkretnych zadań

Ostatni punkt jest kluczowy. FunctionGemma nie jest przeznaczona na chatbota ogólnego przeznaczenia. Została zaprojektowana do fine-tuningu na wąskie, konkretne zadania — dokładnie to, co robią roboty. Robot magazynowy nie musi dyskutować o filozofii. Musi rozumieć “weź pudełko A, przenieś na półkę B” i wykonać to bezbłędnie, tysiące razy dziennie.

Dlaczego roboty zależne od chmury to ślepy zaułek

Obecny paradygmat dla “inteligentnych” robotów jest fundamentalnie zepsuty. Rozważ, co się dzieje, gdy twój robot musi podjąć decyzję:

- Przechwycenie danych z czujników

- Kompresja danych i wysłanie do chmury

- Serwer chmurowy przetwarza żądanie

- Odpowiedź odesłana

- Robot działa

To pięć kroków z wieloma punktami awarii. Zator w sieci? Robot zamiera. Przeciążony serwer? Robot czeka. Awaria internetu? Robot staje się drogim przyciskiem do papieru. I płacisz za każdą milisekundę czasu obliczeniowego i każdy megabajt transferu danych.

Dla pojedynczego odkurzacza domowego to może być do zniesienia. Dla floty 500 robotów magazynowych działających 24/7? Same rachunki za chmurę mogą cię zbankrutować, a opóźnienia sprawiają, że koordynacja w czasie rzeczywistym jest prawie niemożliwa.

Rewolucja edge computingu uderza w robotykę

FunctionGemma reprezentuje filozoficzną zmianę: zamiast pytać “jak sprawić, by roboty były wystarczająco inteligentne, żeby potrzebowały chmury”, Google pyta “jak sprawić, by chmura była wystarczająco mała, żeby zmieściła się w robocie”.

To nie jest bezprecedensowe. Przemysł motoryzacyjny odkrył to lata temu — automatyczne hamowanie awaryjne twojego samochodu nie dzwoni do Google przed podjęciem decyzji o zatrzymaniu. Decyzja następuje lokalnie, w milisekundach, bo opóźnienie zabija (dosłownie). Ale do tej pory modele AI zdolne do rozumienia poleceń w języku naturalnym i przekładania ich na działania były zbyt masywne do wdrożenia edge.

Jak wygląda tania robotyka

Wyobraź sobie domowego robota-asystenta za 900 zł z:

- Pełnym rozumieniem języka naturalnego dla powszechnych poleceń

- Brakiem miesięcznych opłat abonamentowych

- Perfekcyjnym działaniem podczas awarii internetu

- Twoje dane głosowe nigdy nie opuszczają urządzenia

- Natychmiastową reakcją na polecenia

Albo wyobraź sobie roboty rolnicze, które mogą działać na polach bez żadnego zasięgu sieci komórkowej. Drony ratunkowe, które nie potrzebują Starlinka. Towarzysze opieki nad seniorami, którzy nie wymagają subskrypcji chmurowej, by przypomnieć komuś o wzięciu leków.

Oszczędności kumulują się na każdym poziomie. Tańszy sprzęt obliczeniowy oznacza tańsze roboty. Brak zależności od chmury oznacza brak powtarzających się opłat. Lokalne przetwarzanie oznacza prostsze wymagania sieciowe. Prywatność by design oznacza łatwiejsze zatwierdzenie regulacyjne.

Architektura “kontrolera ruchu”

Google nie jest na tyle naiwny, by twierdzić, że FunctionGemma może całkowicie zastąpić duże modele językowe. Ich proponowana architektura jest mądrzejsza: użyj FunctionGemma jako lokalnego “kontrolera ruchu”, który natychmiast obsługuje 90% prostych poleceń, a złożone zapytania kieruje do chmury tylko w razie potrzeby.

Dla robota to mogłoby wyglądać tak:

- Obsługiwane lokalnie: “Jedź do przodu”, “Stop”, “Podnieś czerwony obiekt”, “Wróć do stacji ładowania”

- Kierowane do chmury: “Przeanalizuj ten nietypowy obiekt i powiedz mi, co to jest”, “Zaplanuj optymalną trasę przez to nowe środowisko”

To podejście hybrydowe daje ci szybkość i niezawodność edge computingu dla rutynowych operacji, zachowując jednocześnie dostęp do inteligencji na skalę chmury dla prawdziwych przypadków brzegowych.

Czynnik fine-tuningu

Być może najważniejszym aspektem dla robotyki jest możliwość trenowania FunctionGemma. Bazowa dokładność 58% brzmi okropnie — i tak jest, dla asystenta ogólnego przeznaczenia. Ale dostrojona na konkretne słownictwo poleceń i działań robota, skacze do 85%.

Teraz wyobraź sobie, co się stanie, gdy firma robotyczna dostroi ją specjalnie do swojego przypadku użycia:

- Robot kompletacyjny magazynu: 50 podstawowych poleceń, zoptymalizowane słownictwo, dokładność potencjalnie powyżej 95%

- Dron dostawczy: polecenia nawigacyjne, nadpisania bezpieczeństwa, odpowiedzi pogodowe

- Ramię produkcyjne: precyzyjne instrukcje ruchu, kontrole jakości

Każdy typ robota dostaje dopasowany mózg AI, idealnie dopasowany do swoich potrzeb i wytrenowany dokładnie na słownictwie, z którym się spotka. To przeciwieństwo podejścia “jeden gigantyczny model rządzi wszystkimi” — jest modułowy, wydajny i wdrażalny.

Implikacje dla producentów robotów

Dla firm budujących roboty, FunctionGemma reprezentuje strategiczny punkt zwrotny:

Struktura kosztów się zmienia: Zestawienie materiałowe “inteligentnego” robota może spaść o setki dolarów, gdy nie potrzebujesz drogiego sprzętu sieciowego i redundancji łączności z chmurą.

Model subskrypcyjny umiera: Robot-as-a-Service zależy od zależności od chmury, by zamknąć klientów w powtarzających się płatnościach. Lokalna AI łamie ten model — a klienci to zauważą.

Niezawodność staje się osiągalna: Robot, który może funkcjonować autonomicznie, oznacza gwarantowany czas pracy bez heroicznej infrastruktury sieciowej.

Prywatność staje się funkcją: Dane, które nigdy nie opuszczają urządzenia, nie mogą być zhakowane, wyciekać ani być wezwane do sądu.

Czego brakuje

Nie przesadzajmy. FunctionGemma ma realne ograniczenia:

- Brak wielokrokowego rozumowania: “Weź pudełko, sprawdź etykietę i włóż je do odpowiedniego pojemnika” obecnie przekracza jej możliwości

- Polecenia pośrednie sprawiają trudność: “W pokoju jest za jasno” nie wywoła regulacji oświetlenia

- 15% wskaźnik błędów: W porządku dla wielu zastosowań, niebezpieczny dla innych

Ale to są problemy programistyczne ze znanymi rozwiązaniami. Wielokrokowe rozumowanie to jest właśnie do czego służy chain-of-thought prompting. Polecenia pośrednie można obsłużyć przez fine-tuning na parafrazach. Wskaźniki błędów spadną z większymi zestawami danych treningowych i iteracjami modelu.

Ograniczenia sprzętowe — to jest trudny problem. A Google właśnie udowodnił, że 270 milionów parametrów wystarcza do praktycznego wywoływania funkcji. To jest przełom.

Szerszy obraz

FunctionGemma sama nie stworzy rewolucji robotów. Ale to proof of concept, którego przemysł AI desperacko potrzebował: nie potrzebujesz modelu z bilionem parametrów, żeby uczynić maszyny użytecznymi. Potrzebujesz modelu o odpowiednim rozmiarze do odpowiedniego zadania.

Implikacje wykraczają poza robotykę do IoT, urządzeń noszonych, urządzeń medycznych i wszystkiego innego, co musi podejmować decyzje bez dzwonienia do domu. Ale konkretnie dla robotyki to wygląda jak moment, na który branża czekała — moment, w którym “inteligentny robot” przestaje wymagać “drogi robot”.

Przyszłość przystępnej robotyki nie jest w chmurze. Jest w 288 megabajtach starannie wytrenowanych wag, działających lokalnie, reagujących natychmiast, działających wszędzie. Google właśnie dał nam wgląd w to, jak to wygląda. Teraz kolej na producentów robotów, żeby to zbudować.