TRANSLATE START

title: “FunctionGemma: Google’s piepkleine AI voor je telefoon, zonder snoer” # Maximum 65 characters for SEO description: “Google lanceerde FunctionGemma, een minuscule AI met 270M parameters die lokaal op je telefoon draait en spraakcommando’s omzet in acties zonder de cloud. Privacy en snelheid, zonder snoer.” # Meta description: 25-160 characters slug: “functiongemma-googles-tiny-ai-for-your-phone-unplugged” categories: [“AI”, “Mobile”, “Software”] tags: [“functiongemma”, “google”, “on-device-ai”, “small-language-models”, “privacy”, “mobile-technology”]

TRANSLATE END

Technical

draft: false # false by default date: 2025-12-21 authors: [“Robot King”] featuredImage: “/images/shared/magazine/2025-12-21-image001-a514ee65.jpg” featured: true # featured by default

Source Attribution - we do not use this, place links into the content

source: "" # Original source URL (optional)

sourceAuthor: "" # Original author/creator (optional)

Translation metadata

translationKey: “a514ee65-86d0-470e-acda-cc68e35760af” sourceLanguage: “en-us” # Original content language translationStatus: “source” lastTranslated: 2025-12-21T18:51:07+00:00

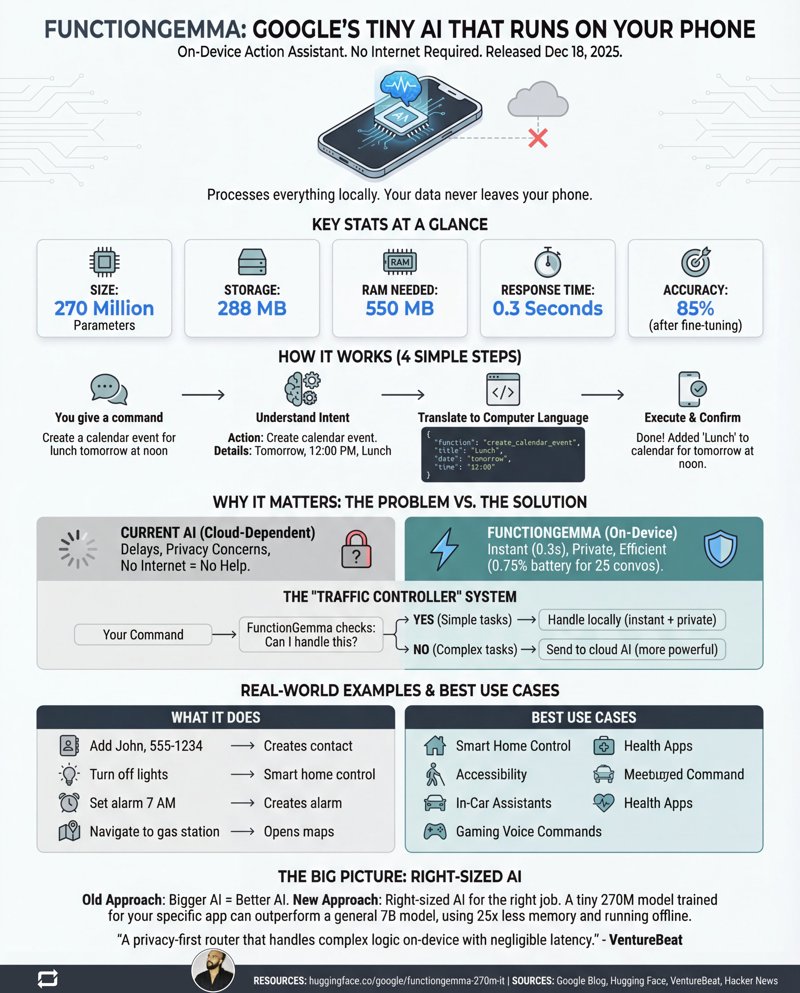

In een wereld waar AI-bedrijven verwikkeld zijn in een brutalistische architectuurrace om het grootste digitale brein te bouwen, heeft Google zojuist iets hilarisch gedaan: het lanceerde er eentje die in je broekzak past. Op 18 december 2025, met de tamtam van een software-patch, slingerde Google FunctionGemma geruisloos de wereld in. Dit is geen gigant van biljoenen parameters die in een arctisch datacenter leeft. Het is een minuscule model met 270 miljoen parameters, ontworpen om één ding uitzonderlijk goed te doen: op je telefoon leven en dingen regelen, zonder internet.

Terwijl de rest van de industrie ‘groter is beter’ scandeert, is FunctionGemma een verfrissende dosis pragmatisme. Het is een gespecialiseerde versie van het Gemma 3 270M model, expliciet getuned voor “function calling”—de beslist onglamoureuze maar cruciale taak om je gesproken woorden om te zetten in code die je apparaat daadwerkelijk kan uitvoeren. Zie het minder als een converserende filosoof en meer als een hyper-efficiënte universele afstandsbediening voor de functies van je telefoon. Het hele uitgangspunt is om de cloudverbinding voor simpele taken door te knippen, waardoor latentie, privacyproblemen en de existentiële angst om nutteloos te zijn zonder signaal worden geëlimineerd.

Klein model, grote implicaties

Laten we het over de cijfers hebben, want die zijn bijna komisch in het huidige AI-landschap. FunctionGemma is een vedergewichtkampioen in een competitie van superzwaargewichten.

- Parameters: 270 miljoen (ter vergelijking: GPT-4 wordt geschat op duizenden keren groter)

- Grootte: Het model weegt ongeveer 288 MB, kleiner dan veel mobiele games die je alleen maar digitale edelstenen willen verkopen.

- RAM-gebruik: Het nipt slechts 550 MB RAM om te draaien.

- Responstijd: Vergeet de retourtrip naar het serverpark. We hebben het over 0,3 seconden voor on-device verwerking.

- Privacy: 100%. Je commando om “een timer in te stellen voor mijn trieste bureaulunch” verlaat je apparaat nooit.

Dit gaat niet alleen over het verkleinen van een groot taalmodel. Het is een andere filosofie. FunctionGemma is ontworpen om de brug te zijn tussen jouw natuurlijke taal en de software van je telefoon, fungerend als een lokale agent die direct een contactpersoon kan aanmaken, je zaklamp kan aan- of uitzetten, of een agenda-afspraak kan instellen.

De ‘Verkeersregelaar’-gok

Google suggereert niet dat deze 270M parameter ‘ukkie’ zijn cloud-gebaseerde titanen zal vervangen. In plaats daarvan positioneert het zich als een intelligente ‘verkeersregelaar’. Het idee is briljant eenvoudig: als een commando rechttoe rechtaan is (“Doe de lichten uit”), FunctionGemma het lokaal afhandelt voor een instant, privéreactie. Als je een complexere vraag stelt (“Wat is de geschiedenis van de Peloponnesische Oorlog en kun je het samenvatten als een zeezang?”), kent het zijn grenzen en stuurt het de query slim door naar een krachtiger cloud-gebaseerd model zoals Gemma 3 27B.

Deze hybride aanpak geeft je het beste van twee werelden: de snelheid en privacy van edge computing voor de 90% van de taken die geen redenering op planetaire schaal vereisen, en de pure kracht van de cloud voor wanneer je die echt nodig hebt. Het is een systeem dat is ontworpen om efficiënt te zijn, niet alleen krachtig.

Finetuning is het geheime wapen

Direct uit de doos is FunctionGemma niet perfect. In Google’s eigen “Mobile Actions”-evaluatie was de basisnauwkeurigheid een grondig middelmatige 58%. Maar hier komt het cruciale deel: het is niet bedoeld om kant-en-klaar te gebruiken. FunctionGemma is een fundament, een stuk zeer trainbare klei.

Na finetuning op een specifieke dataset – in dit geval een lijst met veelvoorkomende telefooncommando’s – schoot de nauwkeurigheid omhoog naar 85%. Die sprong is het hele punt. Google vertelt ontwikkelaars dat een klein, gespecialiseerd model, getraind op jouw specifieke app-functies, een enorm, algemeen model kan overtreffen met een fractie van de middelen. Het is een stap richting op maat gemaakte AI-agenten die experts zijn in hun specifieke domein, geen manusjes-van-alles.

Natuurlijk zijn er beperkingen. Het model heeft momenteel moeite met het aaneenschakelen van meerdere stappen en kan struikelen over indirecte verzoeken. Die 85% nauwkeurigheid betekent ook dat het nog steeds 15% van de tijd de plank misslaat, wat bloedirritant kan zijn als je alleen maar een contactpersoon probeert toe te voegen. Maar als proof of concept is het een krachtig statement.

De toekomst zit in je broekzak, niet alleen in de cloud

FunctionGemma is meer dan alleen een nieuw model; het is een signaal dat de AI-wapenwedloop een nieuwe fase ingaat. De fixatie op het bouwen van steeds grotere ‘godmodellen’ maakt plaats voor een meer genuanceerde strategie waarbij de juiste AI op de juiste plek wordt ingezet. Voor ontwikkelaars opent dit de deur naar het bouwen van slimmere, snellere en privacyvriendelijkere apps zonder afhankelijk te zijn van een constante, dure navelstreng naar de cloud.

Voor de rest van ons betekent het dat de AI-assistent in onze broekzak een stuk responsiever en een stuk minder griezelig wordt. De toekomst van AI is niet slechts één gigantisch brein in een serverpark. Het zijn miljoenen kleine, gespecialiseerde breinen die efficiënt werken precies waar we ze nodig hebben. En het lijkt erop dat een van de eersten zojuist in jouw telefoon is getrokken.