L’industria della robotica ha un piccolo segreto inconfessabile: insegnare ai robot a fare qualsiasi cosa utile è un processo lentissimo e spaventosamente costoso. Per anni, il dogma dominante è stato quello di imporre l’intelligenza a forza bruta con i modelli Vision-Language-Action (VLA), che richiedono decine di migliaia di ore di esseri umani che manovrano meticolosamente i robot come marionette attraverso ogni compito immaginabile. È un collo di bottiglia dei dati di proporzioni bibliche.

Ora, l’azienda di robotica 1X propone una soluzione che rasenta l’eresia. Il loro nuovo approccio per l’umanoide NEO è ingannevolmente semplice: basta con le lezioni estenuanti e si lascia che il robot impari osservando la vasta, caotica e infinitamente istruttiva libreria di comportamenti umani che chiamiamo internet. Questo non è solo un aggiornamento; è un cambiamento fondamentale nel modo in cui un robot può acquisire competenze.

La Bestia Affamata di Dati di Ieri

Per apprezzare il salto che 1X sta compiendo, bisogna capire lo status quo. La maggior parte dei moderni modelli di base per la robotica, da Helix di Figure a GR00T di Nvidia, sono VLA. Questi modelli sono potenti, ma sono insaziabilmente affamati di dati di dimostrazione di alta qualità e specifici per i robot. Ciò significa pagare persone per teleoperare i robot per migliaia di ore per raccogliere esempi di, diciamo, prendere una tazza o piegare un asciugamano.

Questo approccio è un ostacolo significativo alla creazione di robot veramente multiuso. È costoso, non si adatta bene su larga scala e i modelli risultanti possono essere fragili, fallendo quando si trovano di fronte a un oggetto o un ambiente che non hanno mai visto prima. È come cercare di insegnare a un bambino a cucinare permettendogli solo di guardarti nella tua cucina, invece di lasciargli fare una scorpacciata di tutti i cooking show mai realizzati.

Sognare un Pochino di… Faccende Domestiche

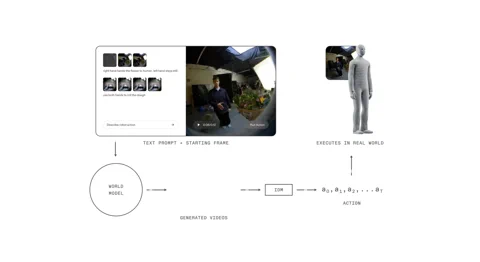

L’1X World Model (1XWM) getta quel copione dalla finestra. Invece di mappare direttamente il linguaggio alle azioni, utilizza la generazione video condizionata dal testo per capire cosa fare. È un cervello in due parti che permette al robot di immaginare il futuro prima di agire.

Per prima cosa, c’è il World Model (WM), un modello video generativo da 14 miliardi di parametri che agisce come l’immaginazione del sistema. Si dà a NEO un prompt testuale — “metti quest’arancia nella scatola del pranzo” — e il WM, osservando la scena attuale, si immagina un breve e plausibile video del compito completato.

Poi, l’Inverse Dynamics Model (IDM), il pragmatista della macchina, analizza quel sogno. Traduce i pixel generati in una sequenza concreta di comandi motori, colmando il divario tra un cosa visivo e un come fisico. Questo processo è radicato attraverso una strategia di addestramento multistadio: il modello inizia con video su scala web, viene addestrato a metà con 900 ore di video umani egocentrici per ottenere una prospettiva in prima persona, e infine affinato su sole 70 ore di dati specifici per NEO per adattarsi al proprio corpo.

Un trucco intelligente nella loro pipeline di addestramento è l’“upsampling delle didascalie”. Poiché molti set di dati video hanno descrizioni concise, 1X utilizza un VLM per generare didascalie più ricche e dettagliate. Ciò fornisce un condizionamento più chiaro e migliora la capacità del modello di seguire istruzioni complesse, una tecnica che ha mostrato benefici simili nei modelli di immagini come DALL-E 3 di OpenAI.

Il Vantaggio Umanoide

Questo intero approccio incentrato sul video si fonda su un pezzo di hardware cruciale, e forse scontato: il robot ha la forma di una persona. L’1XWM, addestrato su innumerevoli ore di esseri umani che interagiscono con il mondo, ha sviluppato una profonda e implicita comprensione dei principi fisici — gravità, slancio, attrito, affordance degli oggetti — che si trasferiscono direttamente perché il corpo di NEO si muove in un modo fondamentalmente simile a quello umano.

Come afferma 1X, l’hardware è un “cittadino di prima classe nello stack AI”. Le similitudini cinematiche e dinamiche tra NEO e un essere umano significano che i principi appresi dal modello rimangono generalmente validi. Ciò che il modello può visualizzare, NEO, il più delle volte, può effettivamente fare. Questa stretta integrazione di hardware e software colma il divario spesso insidioso tra simulazione e realtà.

Dalla Teoria alla Realtà (Con Qualche Inciampo)

I risultati sono convincenti. 1XWM permette a NEO di generalizzare a compiti e oggetti per i quali non ha dati di addestramento diretti. Il video promozionale lo mostra stirare una camicia, annaffiare una pianta e persino azionare un sedile del WC — un compito per il quale non aveva esempi precedenti. Ciò suggerisce che la conoscenza per la coordinazione a due mani e l’interazione complessa con gli oggetti viene trasferita con successo dai dati video umani.

Ma non è magia. Il sistema ha i suoi limiti. Le generazioni simulate possono essere “eccessivamente ottimiste” riguardo al successo, e il suo pre-addestramento monoculare può portare a una scarsa comprensione 3D, facendo sì che il robot reale sottostimi o sovrastimi un obiettivo anche quando il video generato sembra perfetto. I tassi di successo su compiti di destrezza come versare cereali o disegnare una faccina sorridente rimangono sfide.

Tuttavia, 1X ha trovato un modo promettente per aumentare le prestazioni: il calcolo al momento del test (test-time compute). Per un compito di “prendere un fazzoletto”, il tasso di successo è balzato dal 30% con una singola generazione video al 45% quando al sistema è stato permesso di generare otto diversi futuri possibili e selezionare il migliore. Sebbene questa selezione sia attualmente manuale, indica un futuro in cui un valutatore VLM potrebbe automatizzare il processo, migliorando significativamente l’affidabilità.

Il Volano dell’Autoapprendimento

L’1XWM rappresenta più di un aggiornamento incrementale; è un potenziale cambio di paradigma che potrebbe spalancare il collo di bottiglia dei dati. Crea un volano per l’auto-miglioramento. Essendo in grado di tentare un’ampia gamma di compiti con un tasso di successo non nullo, NEO può ora generare i propri dati. Ogni azione, sia essa un successo o un fallimento, diventa un nuovo esempio di addestramento che può essere reintrodotto nel modello per affinare la sua politica. Il robot inizia a insegnare a se stesso.

Naturalmente, rimangono ostacoli importanti. Il WM impiega attualmente 11 secondi per generare un piano di 5 secondi, con un altro secondo per l’IDM per estrarre le azioni. Quella latenza è un’eternità in un ambiente dinamico e reale e un punto di partenza impossibile per compiti reattivi o manipolazioni delicate e ricche di contatto.

Eppure, affrontando di petto il problema dei dati, 1X potrebbe aver appena spalancato la porta a un futuro in cui i robot imparano non dalle nostre noiose istruzioni, ma dalla nostra esperienza collettiva e registrata. Quel futuro sta accelerando, un video di internet alla volta.