title: “FunctionGemma: L’AI Tascabile di Google per il Tuo Telefono, Senza Fili” # Maximum 65 characters for SEO description: “Google ha appena rilasciato FunctionGemma, un’AI minuscola da 270M parametri che gira localmente sul tuo telefono, trasformando i comandi vocali in azioni senza il cloud. Privacy e velocità, disconnesse.” # Meta description: 25-160 characters slug: “functiongemma-googles-tiny-ai-for-your-phone-unplugged” categories: [“AI”, “Mobile”, “Software”] tags: [“functiongemma”, “google”, “on-device-ai”, “small-language-models”, “privacy”, “mobile-technology”]

Technical

draft: false date: 2025-12-21 authors: [“Robot King”] featuredImage: “/images/shared/magazine/2025-12-21-image001-a514ee65.jpg” featured: true

Source Attribution - we do not use this, place links into the content

source: "" # Original source URL (optional)

sourceAuthor: "" # Original author/creator (optional)

Translation metadata

translationKey: “a514ee65-86d0-470e-acda-cc68e35760af” sourceLanguage: “en-us” translationStatus: “source” lastTranslated: 2025-12-21T18:51:07+00:00

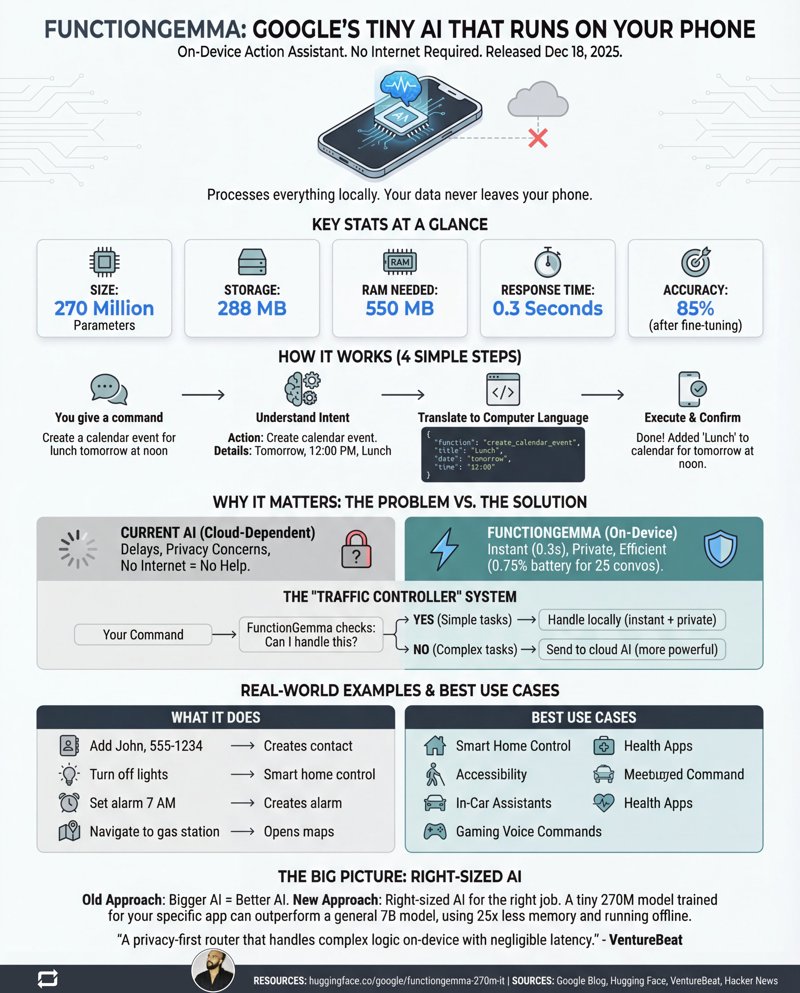

In un mondo dove le aziende di IA sono impegnate in una corsa agli armamenti architettonici brutalisti per costruire il cervello digitale più imponente, Google ha appena fatto qualcosa di esilarante: ha tirato fuori dal cilindro una versione tascabile. Il 18 dicembre 2025, con la stessa enfasi di una nota di patch software, Google ha silenziosamente lanciato FunctionGemma nel mondo. Non stiamo parlando di un altro colosso da trilioni di parametri che dimora in un data center artico. Si tratta di un modello minuscolo, da 270 milioni di parametri, progettato per fare una cosa eccezionalmente bene: vivere sul tuo telefono e portare a termine compiti, senza bisogno di internet.

Mentre il resto dell’industria canta a squarciagola “più grande è meglio”, FunctionGemma è una boccata d’aria fresca di puro pragmatismo. È una versione specializzata del modello Gemma 3 270M, esplicitamente ottimizzata per la “function calling” – il compito decisamente poco affascinante ma cruciale di trasformare le tue parole pronunciate in codice che il tuo dispositivo può effettivamente eseguire. Pensala meno come una filosofa conversazionale e più come un telecomando universale iper-efficiente per le funzionalità del tuo telefono. L’intera premessa è recidere il cordone ombelicale con il cloud per i compiti semplici, eliminando latenza, problemi di privacy e la paura esistenziale di essere inutile senza segnale.

Piccolo Modello, Grandi Implicazioni

Parliamo di numeri, perché sono quasi comici nel panorama attuale dell’IA. FunctionGemma è un campione dei pesi piuma in un campionato di super-massimi.

- Parametri: 270 milioni (per contesto, GPT-4 è stimato essere migliaia di volte più grande)

- Dimensioni: Il modello si attesta intorno ai 288 MB, più piccolo di molti giochi mobili che vogliono solo venderti gemme digitali.

- Utilizzo RAM: Consuma appena 550 MB di RAM per funzionare.

- Tempo di risposta: Dimentica il viaggio di andata e ritorno alla server farm. Parliamo di 0,3 secondi per l’elaborazione sul dispositivo.

- Privacy: 100%. Il tuo comando “imposta un timer per il mio triste pranzo alla scrivania” non lascia mai il tuo dispositivo.

Non si tratta solo di rimpicciolire un modello linguistico di grandi dimensioni. È una filosofia diversa. FunctionGemma è progettata per essere il ponte tra il tuo linguaggio naturale e il software del tuo telefono, agendo come un agente locale in grado di creare un contatto, accendere la torcia o impostare un evento nel calendario all’istante.

La Mossa del “Controllore di Traffico”

Google non sta suggerendo che questo peso piuma da 270M parametri sostituirà i suoi titani basati su cloud. Invece, lo sta posizionando come un intelligente “controllore di traffico”. L’idea è genialmente semplice: se un comando è diretto (“Spegni le luci”), FunctionGemma lo gestisce localmente per una risposta istantanea e privata. Se fai una domanda più complessa (“Qual è la storia della Guerra del Peloponneso e puoi riassumerla come una canzone marinaresca?”), conosce i suoi limiti e instrada intelligentemente la query a un modello basato su cloud più potente come Gemma 3 27B.

Questo approccio ibrido ti offre il meglio di entrambi i mondi: la velocità e la privacy dell’edge computing per il 90% dei compiti che non richiedono un ragionamento su scala planetaria, e la potenza bruta del cloud per quando ne hai effettivamente bisogno. È un sistema progettato per essere efficiente, non solo potente.

La Rifinitura è la Salsa Segreta

Appena uscito dalla scatola, FunctionGemma non è perfetto. Nella valutazione “Mobile Actions” di Google, la sua precisione di base era un mediocre 58%. Ma ecco la parte cruciale: non è pensato per essere usato così com’è. FunctionGemma è una base, un pezzo di argilla altamente addestrabile.

Dopo essere stato sottoposto a fine-tuning su un dataset specifico – in questo caso, un elenco di comandi telefonici comuni – la sua precisione è schizzata all'85%. Questo balzo è il fulcro della questione. Google sta dicendo agli sviluppatori che un modello piccolo e specializzato, addestrato sulle funzioni specifiche della tua app, può superare un modello massiccio e generico utilizzando una frazione delle risorse. È un passo verso agenti IA su misura che sono esperti nel loro dominio ristretto, non dei tuttologi.

Naturalmente, ci sono delle limitazioni. Il modello attualmente fatica a concatenare più passaggi e può inciampare in richieste indirette. Quell'85% di precisione significa anche che sbaglia ancora il 15% delle volte, il che potrebbe essere esasperante quando stai solo cercando di aggiungere un contatto. Ma come prova di concetto, è un’affermazione potente.

Il Futuro è nella Tua Tasca, Non Solo nel Cloud

FunctionGemma è più di un semplice nuovo modello; è un segnale che la corsa agli armamenti dell’IA sta entrando in una nuova fase. L’ossessione di costruire “modelli divini” sempre più grandi sta lasciando il posto a una strategia più sfumata, dove l’IA della giusta dimensione viene impiegata per il lavoro giusto. Per gli sviluppatori, questo apre le porte alla creazione di app più intelligenti, veloci e private senza fare affidamento su un costante e costoso cordone ombelicale con il cloud.

Per il resto di noi, significa che l’assistente IA nella nostra tasca sta per diventare molto più reattivo e molto meno inquietante. Il futuro dell’IA non è solo un unico cervello gigante in una server farm. Sono milioni di cervelli minuscoli e specializzati che lavorano in modo efficiente proprio dove ne abbiamo bisogno. E sembra che uno dei primi si sia appena trasferito nel tuo telefono.