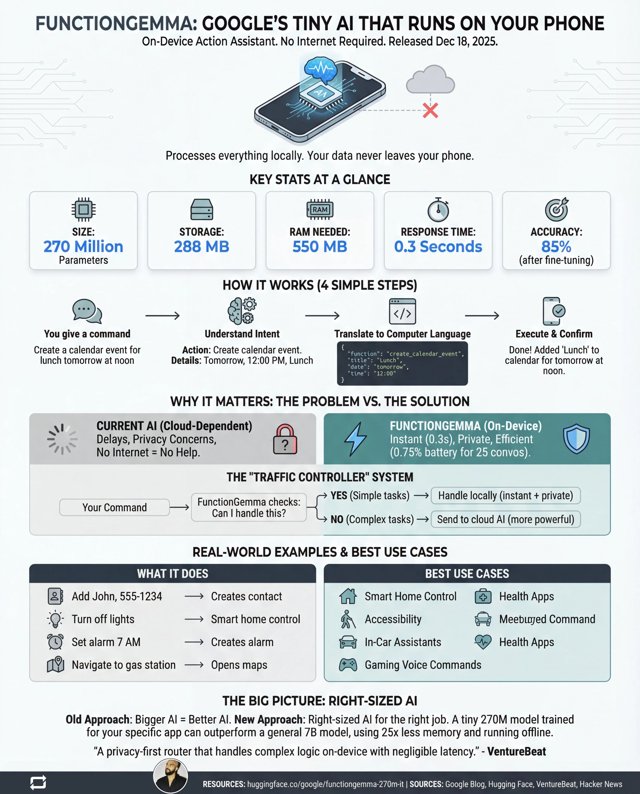

Le 18 décembre 2025, Google a discrètement lancé FunctionGemma, un minuscule modèle d’IA de 270 millions de paramètres conçu pour fonctionner entièrement sur l’appareil. Le communiqué de presse parlait de smartphones — définir des rappels, allumer la lampe torche, les trucs habituels d’assistant numérique. Mais caché dans ces spécifications se trouve quelque chose de bien plus intéressant : un plan pour rendre les robots drastiquement moins chers.

Voici le petit secret inavoué des robots “intelligents” d’aujourd’hui : la plupart ne sont pas intelligents du tout. Ce sont des terminaux. L’intelligence vit quelque part dans un centre de données à des milliers de kilomètres, connectée par un lien internet qui ajoute de la latence, coûte de l’argent, et plante dès qu’on entre dans une zone blanche. Chaque fois que votre robot d’entrepôt doit prendre une décision, il appelle la maison comme un ado nerveux demandant la permission.

FunctionGemma change complètement la donne.

Les chiffres qui comptent

Laissons tomber le blabla marketing et regardons ce qui compte vraiment pour la robotique :

- 288 Mo d’empreinte stockage – Tient sur les microcontrôleurs les moins chers

- 550 Mo de RAM – Un Raspberry Pi 4 a 8 Go de réserve

- 0,3 seconde de temps de réponse – Sur l’appareil, sans aller-retour réseau

- 58% de précision de base → 85% après fine-tuning – Entraînable pour des tâches spécifiques

Ce dernier point est crucial. FunctionGemma n’est pas conçu pour être un chatbot généraliste. Il est conçu pour être affiné sur des tâches étroites et spécifiques — exactement ce que font les robots. Un robot d’entrepôt n’a pas besoin de discuter philosophie. Il doit comprendre “prends le carton A, déplace-le vers l’étagère B” et l’exécuter parfaitement, des milliers de fois par jour.

Pourquoi les robots dépendants du cloud sont une impasse

Le paradigme actuel des robots “intelligents” est fondamentalement cassé. Considérez ce qui se passe quand votre robot doit prendre une décision :

- Données des capteurs capturées

- Données compressées et envoyées au cloud

- Serveur cloud traite la requête

- Réponse renvoyée

- Robot agit

C’est cinq étapes avec de multiples points de défaillance. Congestion réseau ? Le robot gèle. Serveur surchargé ? Le robot attend. Panne internet ? Le robot devient un presse-papier hors de prix. Et vous payez chaque milliseconde de temps de calcul et chaque mégaoctet de transfert de données.

Pour un seul aspirateur domestique, ça peut être tolérable. Pour une flotte de 500 robots d’entrepôt fonctionnant 24h/24 ? Les factures cloud seules pourraient vous ruiner, et la latence rend la coordination en temps réel quasi impossible.

La révolution de l’edge computing frappe la robotique

FunctionGemma représente un changement philosophique : au lieu de demander “comment rendre les robots assez intelligents pour avoir besoin du cloud”, Google demande “comment rendre le cloud assez petit pour tenir dans un robot”.

Ce n’est pas sans précédent. L’industrie automobile l’a compris il y a des années — le freinage d’urgence automatique de votre voiture n’appelle pas Google avant de décider de s’arrêter. La décision se fait localement, en millisecondes, parce que la latence tue (littéralement). Mais jusqu’à présent, les modèles d’IA capables de comprendre les commandes en langage naturel et de les traduire en actions étaient trop massifs pour un déploiement edge.

À quoi ressemble la robotique abordable

Imaginez un robot assistant domestique à 200 € avec :

- Compréhension complète du langage naturel pour les commandes courantes

- Pas de frais d’abonnement mensuels

- Fonctionne parfaitement pendant les pannes internet

- Vos données vocales ne quittent jamais l’appareil

- Réponse instantanée aux commandes

Ou imaginez des robots agricoles qui peuvent opérer dans des champs sans aucune couverture mobile. Des drones de secours en cas de catastrophe qui n’ont pas besoin de Starlink pour fonctionner. Des compagnons d’aide aux personnes âgées qui n’ont pas besoin d’un abonnement cloud pour rappeler à quelqu’un de prendre ses médicaments.

Les économies se cumulent à chaque niveau. Du matériel de calcul moins cher signifie des robots moins chers. Pas de dépendance cloud signifie pas de frais récurrents. Traitement local signifie des exigences réseau plus simples. Privacy by design signifie une approbation réglementaire plus facile.

L’architecture “contrôleur de trafic”

Google n’est pas assez naïf pour prétendre que FunctionGemma peut remplacer entièrement les grands modèles de langage. Leur architecture proposée est plus intelligente : utiliser FunctionGemma comme un “contrôleur de trafic” local qui gère immédiatement 90% des commandes simples, et ne route les requêtes complexes vers le cloud que lorsque c’est nécessaire.

Pour un robot, ça pourrait ressembler à :

- Géré localement : “Avance”, “Stop”, “Ramasse l’objet rouge”, “Retourne à la station de charge”

- Routé vers le cloud : “Analyse cet objet inhabituel et dis-moi ce que c’est”, “Planifie un itinéraire optimal à travers ce nouvel environnement”

Cette approche hybride vous donne la vitesse et la fiabilité de l’edge computing pour les opérations de routine, tout en préservant l’accès à l’intelligence à l’échelle du cloud pour les vrais cas limites.

Le facteur fine-tuning

Peut-être l’aspect le plus important pour la robotique est la capacité d’entraînement de FunctionGemma. La précision de base de 58% semble terrible — et c’est le cas, pour un assistant généraliste. Mais affiné sur un vocabulaire spécifique de commandes et actions de robot, elle bondit à 85%.

Maintenant imaginez ce qui se passe quand une entreprise de robotique l’affine spécifiquement pour son cas d’usage :

- Robot de préparation de commandes : 50 commandes de base, vocabulaire optimisé, précision potentiellement au-dessus de 95%

- Drone de livraison : commandes de navigation, annulations de sécurité, réponses météo

- Bras de fabrication : instructions de mouvement précises, contrôles qualité

Chaque type de robot obtient un cerveau IA sur mesure, parfaitement dimensionné pour ses besoins et entraîné exactement sur le vocabulaire qu’il rencontrera. C’est l’opposé de l’approche “un modèle géant pour les gouverner tous” — c’est modulaire, efficace et déployable.

Les implications pour les fabricants de robots

Pour les entreprises qui construisent des robots, FunctionGemma représente un point d’inflexion stratégique :

La structure de coûts change : La nomenclature d’un robot “intelligent” pourrait baisser de centaines d’euros quand on n’a pas besoin de matériel réseau coûteux et de redondance de connectivité cloud.

Le modèle d’abonnement meurt : Le Robot-as-a-Service dépend de la dépendance cloud pour enfermer les clients dans des paiements récurrents. L’IA locale casse ce modèle — et les clients le remarqueront.

La fiabilité devient atteignable : Un robot qui peut fonctionner de manière autonome signifie un temps de disponibilité garanti sans infrastructure réseau héroïque.

La confidentialité devient une fonctionnalité : Les données qui ne quittent jamais l’appareil ne peuvent pas être piratées, fuiter, ou être saisies par voie judiciaire.

Ce qui manque

Ne survendons pas. FunctionGemma a de vraies limitations :

- Pas de raisonnement multi-étapes : “Prends la boîte, vérifie l’étiquette et mets-la dans le bon bac” dépasse actuellement ses capacités

- Les commandes indirectes galèrent : “La pièce est trop lumineuse” ne déclenchera pas un ajustement de l’éclairage

- 15% de taux d’erreur : Acceptable pour beaucoup d’applications, dangereux pour d’autres

Mais ce sont des problèmes logiciels avec des solutions connues. Le raisonnement multi-étapes est ce à quoi sert le chain-of-thought prompting. Les commandes indirectes peuvent être gérées par fine-tuning sur des paraphrases. Les taux d’erreur baisseront avec des jeux de données d’entraînement plus grands et des itérations de modèle.

Les contraintes matérielles — c’est ça le problème difficile. Et Google vient de prouver que 270 millions de paramètres suffisent pour l’appel de fonction pratique. C’est ça la percée.

La vision d’ensemble

FunctionGemma ne va pas créer la révolution des robots à lui seul. Mais c’est une preuve de concept dont l’industrie de l’IA avait désespérément besoin : on n’a pas besoin d’un modèle à mille milliards de paramètres pour rendre les machines utiles. On a besoin du modèle de la bonne taille pour le bon travail.

Les implications s’étendent au-delà de la robotique vers l’IoT, les wearables, les appareils médicaux, et tout ce qui doit prendre des décisions sans appeler la maison. Mais pour la robotique spécifiquement, ça ressemble au moment que l’industrie attendait — le moment où “robot intelligent” cesse de signifier “robot cher”.

L’avenir de la robotique abordable n’est pas dans le cloud. Il est dans 288 mégaoctets de poids soigneusement entraînés, fonctionnant localement, répondant instantanément, marchant partout. Google vient de nous donner un aperçu de ce à quoi ça ressemble. C’est maintenant aux fabricants de robots de le construire.